Os ataques cibernéticos mais do que duplicaram em quatro anos em todo o mundo, de 818 por organização em 2021 para quase 2.000 por organização no ano passado, de acordo com o Fórum Económico Mundial (WEF). Esta é uma estatística impressionante.

E as pequenas empresas estão particularmente expostas, tendo sete vezes mais probabilidade de reportar resiliência cibernética agora do que em 2022. Goste ou não, as ferramentas de inteligência artificial (IA) têm desempenhado um grande papel aqui, não só com o volume crescente de ataques, mas também com a sua sofisticação.

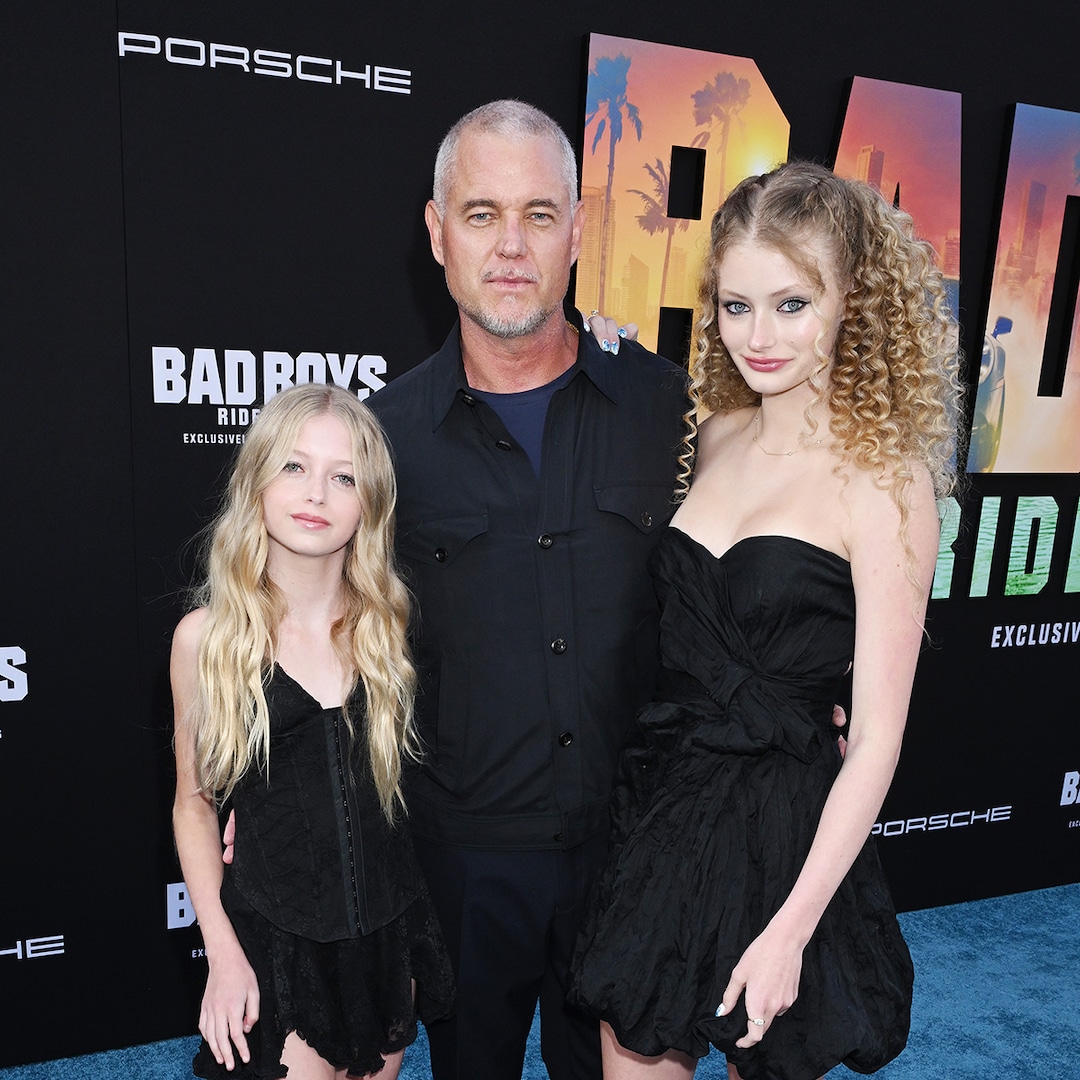

Diretor Sênior de Produtos de Segurança da Alibaba Cloud Intelligence.

Os riscos estão surgindo em todas as camadas da pilha de IA, desde injeção instantânea e vazamento de dados até raspagem de bots e deepfakes alimentados por IA.

Um relatório recente do setor mostra que os invasores estão usando grandes modelos de linguagem (LLMs) para conduzir campanhas persuasivas de phishing, escrever malware polimórfico e automatizar a engenharia social em grande escala.

O resultado é um ambiente de ameaças que aprende, se adapta e se expande mais rápido do que os analistas humanos conseguem responder.

O que há sob as camadas?

Os sistemas de IA são construídos em camadas, cada uma com suas próprias fraquezas. Na camada do ambiente que fornece computação, rede e armazenamento, os riscos são semelhantes aos da TI tradicional, mas a escala e a complexidade das cargas de trabalho de IA tornam os ataques mais difíceis de detectar.

A camada do modelo é onde a manipulação começa. A injeção rápida, a criação de conteúdo não compatível e o vazamento de dados estão agora entre as principais ameaças, destacadas no OWASP 2025 Top 10 para aplicações LLM.

A camada de contexto, que abriga bancos de dados de geração aumentada de recuperação (RAG) e armazenamentos de memória, tornou-se um alvo principal para roubo de dados. Enquanto isso, nas camadas de ferramentas e aplicativos, APIs com privilégios excessivos e agentes de IA mal-intencionados podem fornecer aos invasores as chaves para fluxos de trabalho inteiros.

Por outras palavras, a superfície de ataque está a expandir-se em todas as direcções e, com ela, a necessidade de defesas mais inteligentes. A resposta não é abandonar a IA, mas usá-la para protegê-la. Portanto, uma estrutura de segurança abrangente deve cobrir todo o ciclo de vida da IA, protegendo três camadas principais: a infraestrutura do modelo, o próprio modelo e as aplicações de IA.

Quando a segurança é incorporada aos fluxos de trabalho empresariais, as organizações obtêm proteção eficaz e baixa latência sem sacrificar a conveniência ou o desempenho.

As equipes de segurança já estão implantando cercas inteligentes que analisam solicitações de intenções maliciosas, detectam comportamento anômalo da API e marcam o conteúdo gerado para rastreabilidade.

A última geração de operações de segurança baseadas em IA aplica modelos multiagentes para analisar bilhões de eventos diários, sinalizar riscos emergentes em tempo real e automatizar ações de primeira resposta.

De acordo com a pesquisa Digital Trust Insights 2026 da PwC, a IA está agora no topo da lista de prioridades dos Chief Information Security Officers (CISOs) em todo o mundo, um sinal de que as empresas estão finalmente a tratar a resiliência cibernética como um sistema de aprendizagem e não como uma lista de verificação estática.

Ameaças escondidas nas sombras

No entanto, à medida que as empresas fortalecem as suas defesas, um novo risco, em grande parte auto-infligido, está a emergir nas suas redes. Chama-se Shadow AI. Na maioria das organizações, os funcionários utilizam ferramentas criativas para resumir relatórios, escrever códigos ou analisar clientes, muitas vezes sem autorização oficial ou controles de governança de dados.

De acordo com um relatório da Netskope, cerca de 90% das empresas estão usando aplicativos GenAI atualmente, e mais de 70% dessas ferramentas estão na Shadow IT. Cada prompt ou plug-in não verificado se torna um possível vazamento de dados confidenciais.

A análise interna de todo o setor sugere que quase 45% do tráfego da web relacionado à IA contém informações confidenciais, desde propriedade intelectual até registros de clientes. Paralelamente, os bots alimentados por IA estão proliferando rapidamente. Em seis meses, o tráfego de bots relacionado à coleta de dados e solicitações automatizadas quadruplicou.

Embora a IA prometa operações mais inteligentes e rápidas, também consome volumes cada vez maiores de dados confidenciais, criando mais para defender e mais para perder.

Um cinto de segurança para IA

Os governos e os reguladores estão a começar a reconhecer a escala do desafio. Muitos dos padrões de governança de IA apontam para um futuro onde as organizações demonstrarão não apenas conformidade, mas também visibilidade permanente sobre seus sistemas de IA.

As posturas de segurança devem considerar o treinamento do modelo, a origem dos dados e o comportamento autônomo do agente, e não apenas o tráfego de rede ou os logs de acesso.

Para muitos, isto significa incorporar a segurança diretamente no pipeline de desenvolvimento, adotar arquiteturas de confiança zero e tratar os modelos de IA como ativos vivos que requerem monitoramento constante.

Olhando para o futuro, as linhas de batalha já estão a ser redesenhadas. A próxima fase da segurança cibernética dependerá de um mecanismo duplo: um que proteja os sistemas de IA e outro que também utilize a IA para detectar e neutralizar ameaças.

À medida que os modelos de aprendizado de máquina evoluem, o mesmo acontece com as defesas que os cercam. Regras estáticas e respostas manuais não conseguem acompanhar o ritmo dos invasores que automatizam a criatividade e exploram a velocidade. O que é necessário é um ecossistema que aprenda tão rapidamente quanto se defenda.

Essa mudança já está em andamento. As plataformas de segurança multiagentes coordenam a detecção, triagem e recuperação em bilhões de eventos todos os dias.

Modelos leves e específicos de domínio filtram o ruído, enquanto grandes modelos de raciocínio identificam padrões de ataque nunca antes vistos. É um canal de inteligência que espelha o adversário, só que este é construído para defesa.

Aplicação de inteligência

O futuro da segurança digital será baseado na colaboração entre a visão humana e a intuição da máquina. Em termos práticos, isto significa tanto a reciclagem da mão-de-obra como a reestruturação da infra-estrutura.

São extremamente necessários analistas que possam interpretar os resultados da IA, cientistas de dados que compreendam os riscos e decisores políticos que construam confiança através da transparência. O jogo longo envolve confiança, não apenas resiliência. Confiança de que os sistemas que alimentam a vida moderna estão aprendendo a se proteger.

Porque afinal a IA não é a vilã desta história. Os mesmos algoritmos que tornam os ataques mais poderosos podem tornar a proteção mais precisa. A questão que se coloca aos empregadores em todo o mundo é se irão investir com rapidez suficiente na inteligência, e não na inércia, para definir o próximo capítulo da cibersegurança.

Apresentamos o melhor software de proteção de endpoint.

Este artigo foi produzido como parte do canal Expert Insights da TechRadarPro, onde apresentamos as melhores e mais brilhantes mentes da indústria de tecnologia atualmente. As opiniões expressas aqui são de responsabilidade do autor e não necessariamente da TechRadarPro ou Future plc. Caso tenha interesse em participar, mais informações aqui: