- O Engram da DeepSeek separa a memória estática da computação, aumentando a eficiência em grandes modelos de IA

- O método reduz os requisitos de memória de alta velocidade, permitindo que o DeepSeek use pesquisas de padrões

- Engram suporta pré-busca assíncrona em múltiplas GPUs com sobrecarga mínima de desempenho

DeepSeek, em colaboração com a Universidade de Pequim, apresentou um novo método de treinamento chamado Engram, projetado para desacoplar o armazenamento de memória de processos computacionais.

Os modelos de linguagem tradicionais exigem memória de alta largura de banda para recuperação de conhecimento e computação central, criando um gargalo no desempenho e no custo.

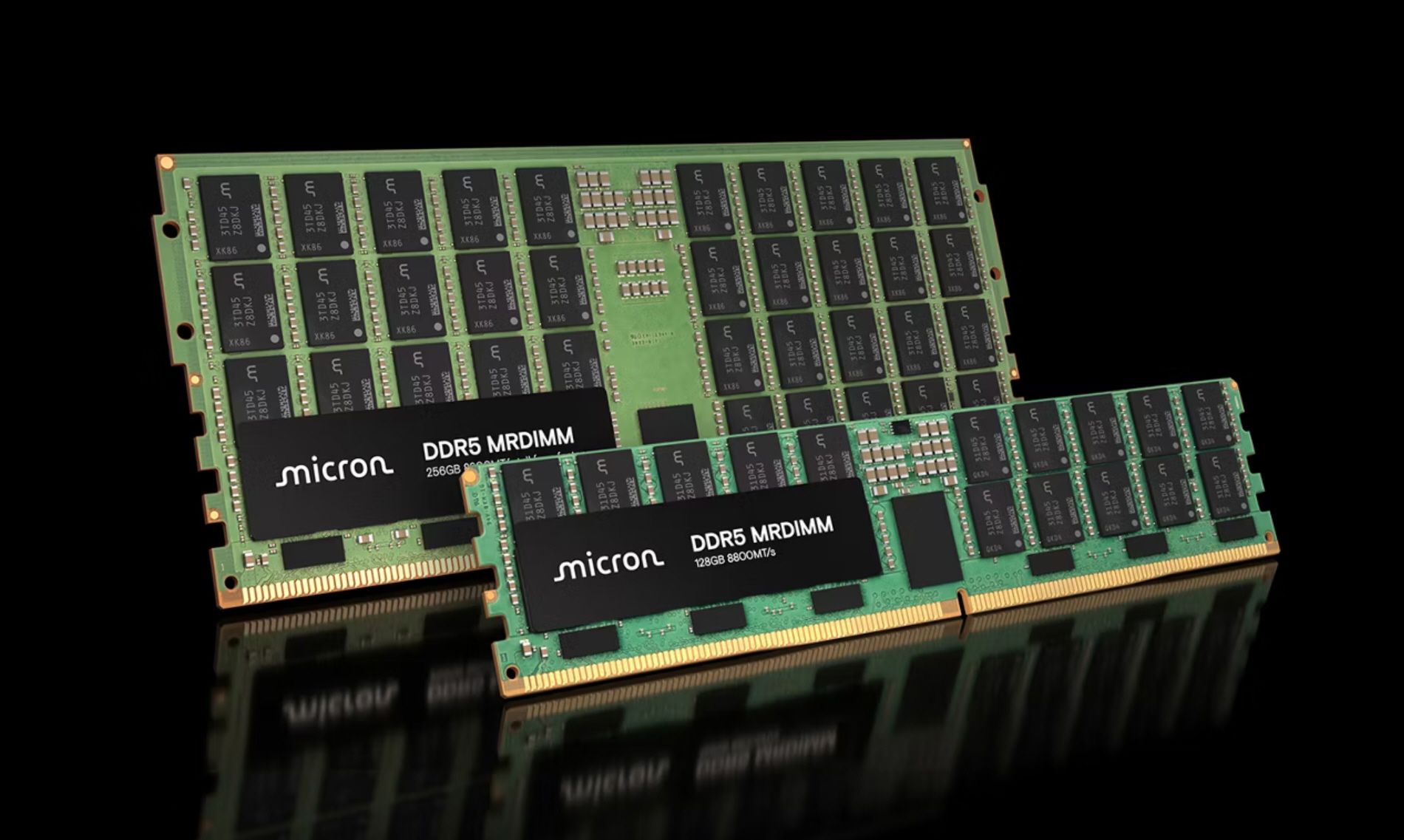

Esse gargalo da HBM é bem conhecido porque os preços da DRAM aumentaram 5 vezes em apenas 10 semanas, à medida que a demanda de hardware suportava grandes modelos de IA.

Validação e abordagem técnica

Os modelos existentes desperdiçam profundidade sequencial em operações triviais que, de outra forma, poderiam apoiar o raciocínio de nível superior, disseram os pesquisadores.

Os engramas permitem que os modelos “procurem” informações importantes com eficiência, sem sobrecarregar a memória da GPU, liberando capacidade para tarefas de raciocínio mais complexas.

O sistema foi testado em um modelo de 27 bilhões de parâmetros e mostrou melhorias mensuráveis em relação aos benchmarks do setor.

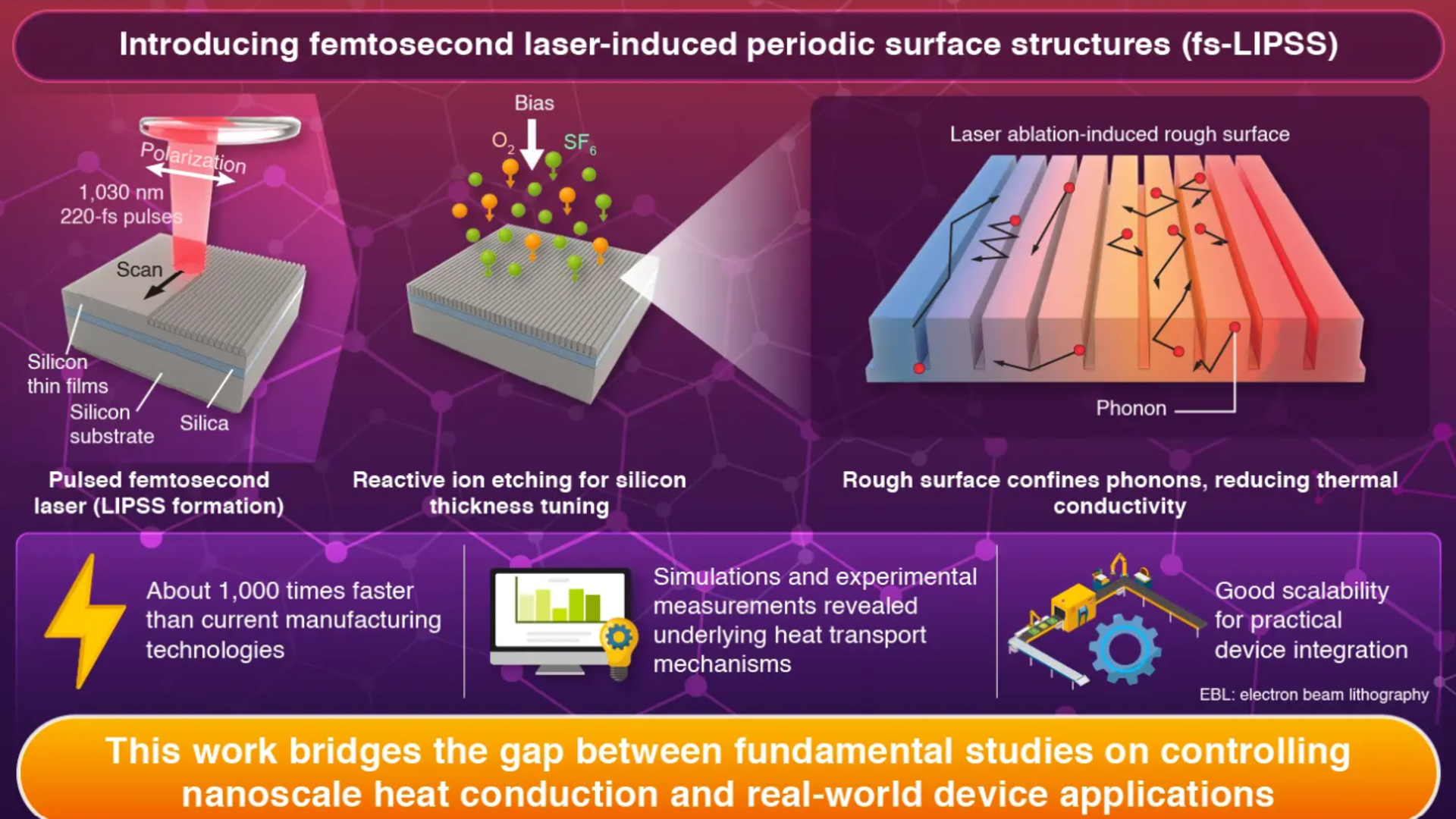

Ao realizar a recuperação de conhecimento por meio de hash de N-gramas, os engramas fornecem acesso à memória estática independente do contexto atual.

As informações recuperadas são então ajustadas usando um mecanismo de controle sensível ao contexto para se alinhar ao estado oculto do modelo.

Esse design permite que os modelos lidem com entradas de contexto longo com mais eficiência e ofereça suporte à pré-busca no nível do sistema com sobrecarga mínima de desempenho.

O método Engram complementa outras abordagens eficientes em termos de hardware, incluindo soluções como os aceleradores de inferência de IA da Phison.

O Engram usa pesquisas de informações estáticas para reduzir a quantidade de memória de alta velocidade necessária, tornando o uso da memória mais eficiente.

Phison oferece uma maneira econômica de expandir a memória total usando SSDs, suportando grandes modelos de IA, como sistemas Engram ou Mixture-of-Experts.

Combinadas, essas abordagens otimizam o uso de memória rápida graças aos sistemas de IA, ao mesmo tempo que aumentam de maneira acessível a capacidade geral de memória.

Ele também funciona junto com o padrão emergente Compute Express Link (CXL), que visa empurrar cargas de trabalho de IA em grande escala para além dos gargalos de memória da GPU.

O método separa o armazenamento de modelo estático da computação dinâmica, melhorando o backbone do Transformer sem aumentar FLOPs ou contagens de parâmetros.

DeepSeek formalizou uma regra de expansão em forma de U para otimizar a atribuição de parâmetros entre o módulo de computação condicional MoE e o módulo de memória Engram.

Os testes mostram que a realocação de cerca de 20-25% do orçamento de parâmetros esparsos produz um melhor desempenho do que o modelo puro do MoE, mantendo lucros estáveis em diferentes escalas.

A expansão do slot de memória fornece melhorias previsíveis sem custo computacional adicional.

Isto confirma a escalabilidade da memória condicional como um eixo independente para modelos esparsos.

O mecanismo de recuperação determinística do Engram permite que a capacidade de memória seja dimensionada linearmente em várias GPUs, ao mesmo tempo que oferece suporte à pré-busca assíncrona na inferência.

Ele descarrega o conhecimento estático das camadas inferiores, liberando mecanismos de atenção para focar no contexto global.

O cache hierárquico de inserções usadas com frequência melhora a eficiência, e o módulo funciona com GPU existente e arquiteturas de memória do sistema, evitando versões caras do HBM.

Essa técnica pode aliviar a pressão sobre hardware de memória caro, especialmente em regiões como a China, onde o acesso da HBM fica atrás de concorrentes como Samsung, SK Hynix e Micron.

A validação inicial do Engram sugere que os modelos podem expandir a escala dos parâmetros e o poder de raciocínio enquanto lidam com as demandas de memória de forma mais eficiente.

Essa abordagem pode ajudar a aliviar as restrições de memória na infraestrutura de IA, reduzindo grandes flutuações nos preços de DRAM DDR5.

Através SCMP

Siga o TechRadar no Google Notícias e adicione-nos como sua fonte padrão para receber notícias, opiniões e opiniões de nossos especialistas em feeds. Certifique-se de clicar no botão Continuar!

E é claro que você também pode Siga o TechRadar no TikTok para receber novidades, análises, unboxings em formato de vídeo e receber atualizações constantes nossas WhatsApp também