- O HBF oferece dez vezes a capacidade do HBM, permanecendo mais lento que o DRAM

- As GPUs acessarão conjuntos de dados maiores por meio da memória em camadas HBM-HBF

- As gravações no HBF são limitadas e o software deve se concentrar nas leituras

A explosão das cargas de trabalho de IA colocou uma pressão sem precedentes nos sistemas de memória, forçando as empresas a repensar a forma como enviam dados aos aceleradores.

A memória de alta largura de banda (HBM) tem servido como um cache rápido para GPUs, permitindo que ferramentas de IA leiam e processem dados de valor-chave (KV) com eficiência.

No entanto, o HBM é caro, rápido e tem capacidade limitada, enquanto o flash de alta largura de banda (HBF) oferece um volume muito maior em velocidades mais lentas.

Como a HBF forma a HBM

O design do HBF permite que a GPU acesse um conjunto maior de dados, limitando o número de gravações a aproximadamente 100.000 por módulo, o que requer software para priorizar leituras em vez de gravações.

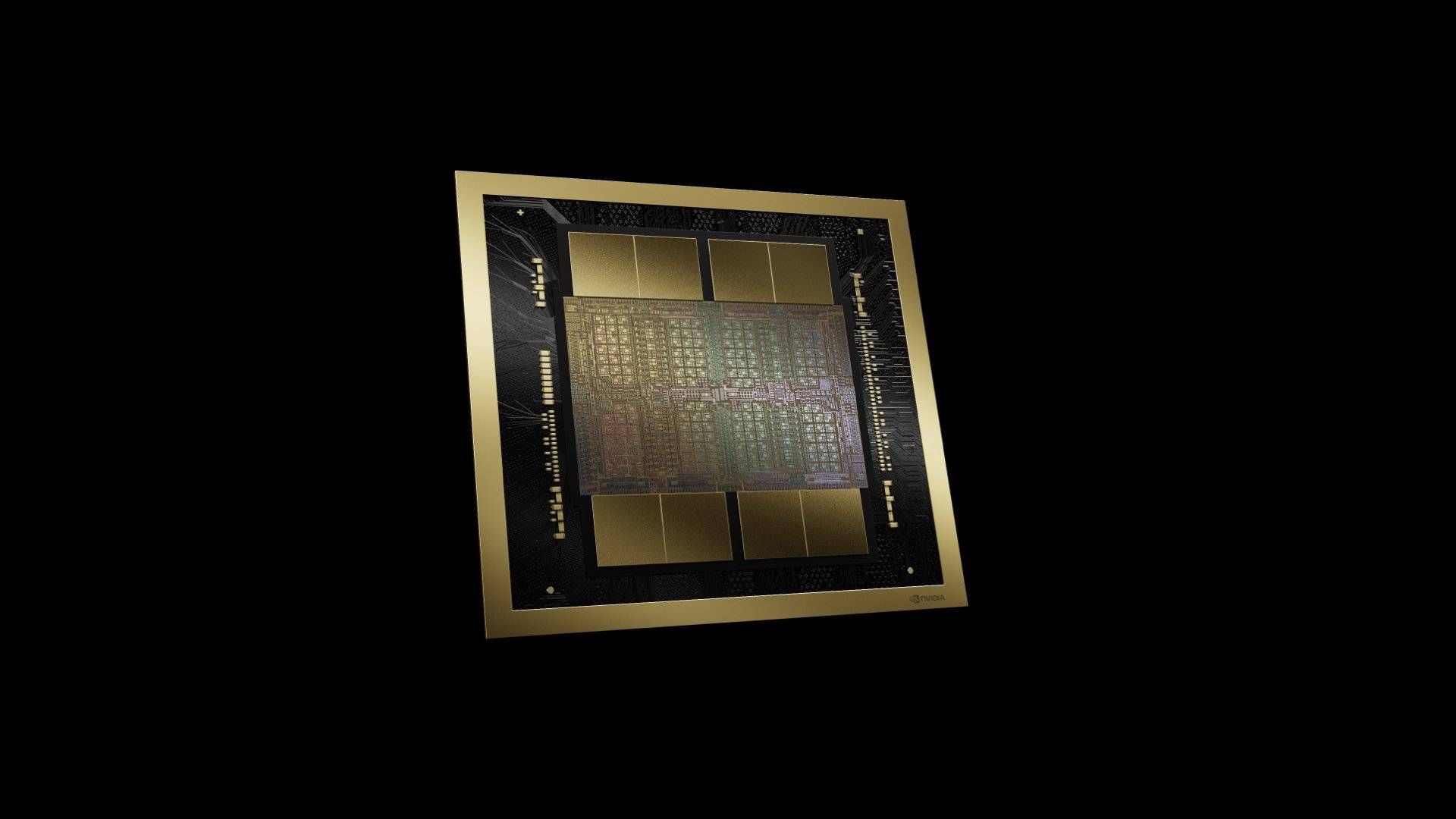

O HBF será integrado ao HBM próximo aos aceleradores de IA, formando uma arquitetura de memória em camadas.

O professor Kim Joungho do KAIST compara o HBM a uma estante doméstica para aprendizado rápido, enquanto o HBF funciona como uma biblioteca com muito mais conteúdo, mas com acesso mais lento.

“Para que uma GPU faça inferência de IA, ela precisa ler dados variáveis chamados cache KV do HBM. Em seguida, ela interpreta isso e cospe-os literalmente, e acho que usará HBF para esta tarefa”, disse o professor Kim.

“O HBM é rápido, o HBF é lento, mas sua capacidade é 10 vezes maior. Porém, embora o HBF não tenha limite de leitura, ele tem limite de escrita, cerca de 100.000. Portanto, quando OpenAI ou Google escrevem programas, eles devem estruturar seu software para focar nas leituras.”

Espera-se que o HBF seja lançado com o HBM6, onde múltiplas pilhas HBM são reunidas em uma rede, aumentando a largura de banda e a capacidade.

O conceito prevê futuras iterações como o HBM7 operando como “fábricas de memória”, onde os dados podem ser processados diretamente do HBF sem desvios pelas redes de armazenamento tradicionais.

O HBF empilha vários killers 3D NAND verticalmente, semelhante ao empilhamento DRAM da HBM, e os interconecta com vias de silício (TSVs).

Uma única unidade HBF pode atingir capacidade de 512 GB e largura de banda de 1.638 TBps, superando as velocidades SSD NVMe PCIe 4.0 padrão.

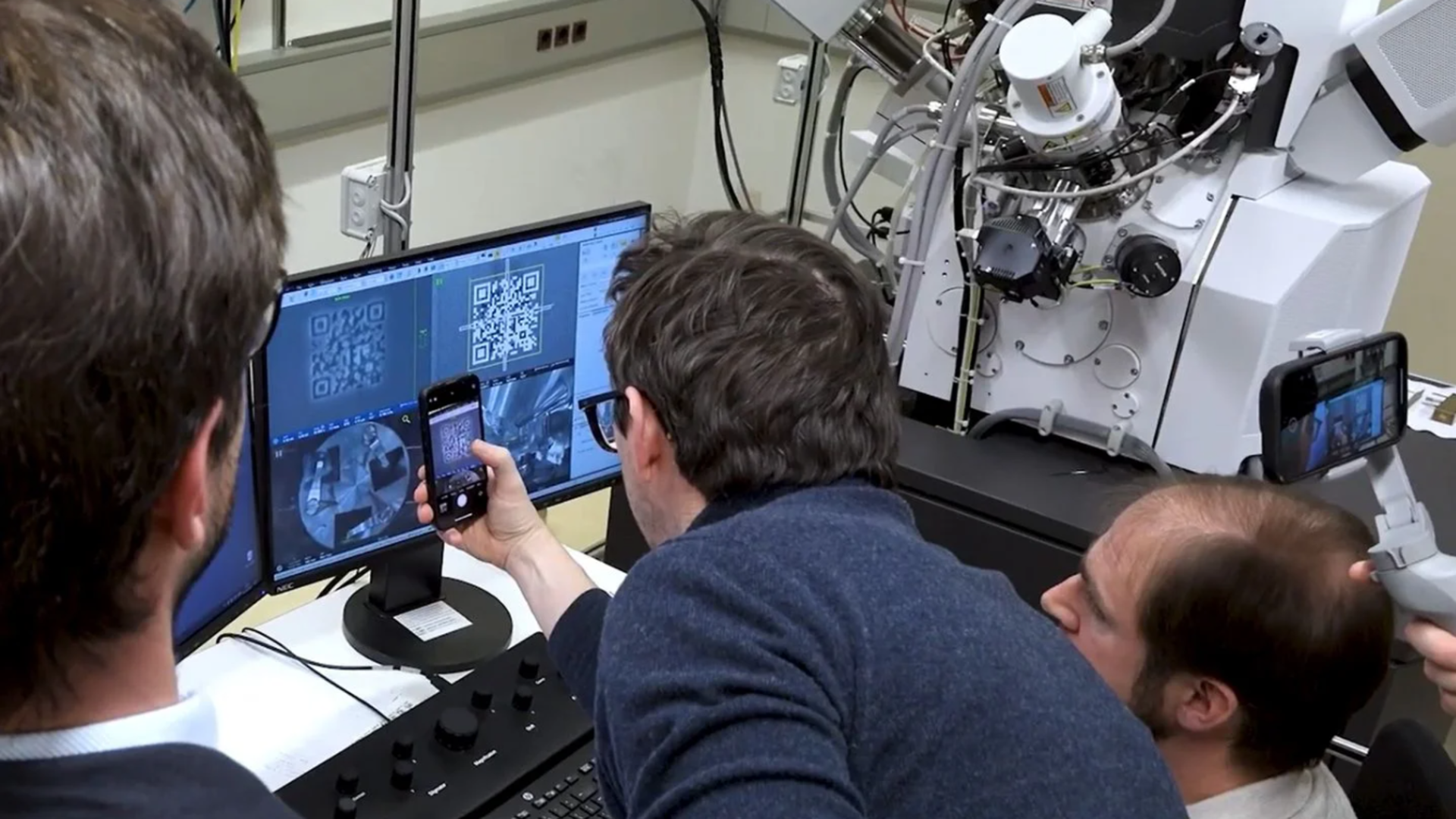

SK Hynix e Sandisk mostraram diagramas mostrando as camadas NAND acima de uma matriz lógica básica conectada via TSVs, formando uma pilha funcional.

Os protótipos de chips HBF requerem fabricação cuidadosa para evitar deformação nas camadas inferiores, e pilhas NAND adicionais aumentariam a complexidade das conexões TSV.

Samsung Electronics e Sandisk planejam adicionar HBF aos produtos Nvidia, AMD e Google AI nos próximos 24 meses.

A SK Hynix lançará um protótipo no final do mês, enquanto as empresas também trabalham na padronização por meio de um consórcio.

Espera-se que a adoção do HBF acelere na era HBM6, e a Kioxia já criou um protótipo de um módulo HBF de 5 TB usando PCIe Gen 6 x8 a 64 Gbps. O professor Kim prevê que o mercado de HBF poderá ultrapassar o HBM até 2038.

Através Sisajorna (originalmente em coreano)

Siga o TechRadar no Google Notícias e adicione-nos como sua fonte padrão para receber notícias, opiniões e opiniões de nossos especialistas em feeds. Certifique-se de clicar no botão Continuar!

E é claro que você também pode Siga o TechRadar no TikTok para receber novidades, análises, unboxings em formato de vídeo e receber atualizações constantes nossas WhatsApp também