- GTIG descobriu que os agentes de ameaças estão clonando modelos maduros de IA usando ataques de destilação

- Malware sofisticado pode usar IA para manipular código em tempo real para evitar detecção

- Grupos patrocinados pelo Estado estão criando kits de phishing e campanhas de engenharia social altamente convincentes

Se você usou ferramentas modernas de IA, saberá que elas podem ajudar a reduzir tarefas mundanas e complicadas.

Bem, os agentes de ameaças pensam da mesma forma, com o último relatório do Google Threat Intelligence Group AI Threat Tracker mostrando que os invasores estão usando IA mais do que nunca.

Desde a análise de como os modelos de IA raciocinam para cloná-los até incorporá-los em cadeias de ataque para evitar a detecção tradicional baseada na Web, o GTIG revelou as ameaças mais sérias – eis o que eles encontraram.

Como os agentes de ameaças usam IA em seus ataques

Para começar, o GTIG descobriu que os agentes de ameaças estão usando cada vez mais “ataques de destilação” para clonar rapidamente grandes padrões de linguagem, para que os agentes de ameaças possam usá-los para seus próprios fins. Os invasores usarão o grande volume de perguntas para aprender como o LLM raciocina as consultas e usarão as respostas para treinar seu modelo.

Os invasores podem usar seu modelo para evitar pagar pelo serviço legítimo, usar o modelo destilado para analisar como o LLM é construído ou encontrar maneiras de explorar seu modelo, que também pode ser usado para explorar o serviço legítimo.

A IA também está sendo usada para apoiar a coleta de informações e campanhas de engenharia social. Tanto os grupos patrocinados pelo Estado iraniano como o norte-coreano utilizaram ferramentas de IA desta forma, os primeiros utilizando a IA para recolher informações sobre relações comerciais para criar um pretexto para contactos, e os últimos utilizando a IA para reunir informações para ajudar a planear ataques.

O GTIG também viu um aumento no uso de IA para criar kits de phishing altamente convincentes para coletar credenciais para distribuição em massa.

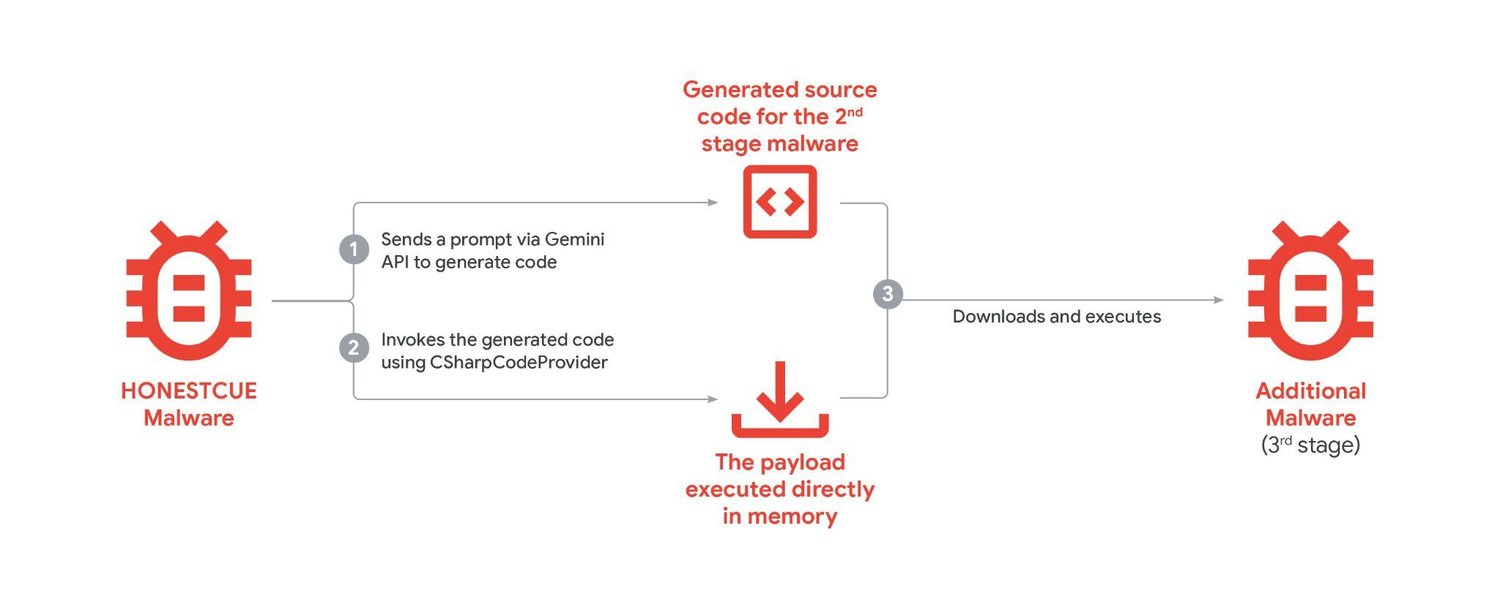

Além disso, alguns agentes de ameaças estão integrando modelos de IA em seus malwares para se adaptarem e evitarem a detecção. Um exemplo, rastreado como HONESTCUE, contornou a detecção baseada em rede e a análise estática usando o Gemini para reescrever e executar código durante um ataque.

Mas nem todos os agentes de ameaças são criados iguais. O GTIG também observou que há uma forte demanda por ferramentas de IA personalizadas criadas para invasores, com demandas específicas por ferramentas capazes de escrever código para malware. Por enquanto, os invasores dependem do uso de ataques de destilação para criar padrões personalizados para uso ofensivo.

Mas se essas ferramentas estivessem disponíveis e fossem fáceis de distribuir, os agentes de ameaças provavelmente adotariam rapidamente a IA maliciosa como vetores de ataque para melhorar o desempenho de campanhas de malware, phishing e engenharia social.

Para se defender contra malware aumentado por IA, muitas soluções de segurança estão implantando suas próprias ferramentas de IA para combatê-lo. Em vez de depender de análises estáticas, a IA pode ser usada para analisar ameaças potenciais em tempo real para descobrir o comportamento de malware aumentado por IA.

A IA também está sendo usada para verificar e-mails e mensagens para detectar phishing em tempo real, na escala de milhares de horas de trabalho humano.

Além disso, o Google está procurando ativamente por possíveis usos maliciosos de IA no Gemini e lançou uma ferramenta para ajudar a encontrar vulnerabilidades de software (Big Sleep) e uma ferramenta para ajudar a corrigir vulnerabilidades (CodeMender).

O melhor antivírus para cada orçamento