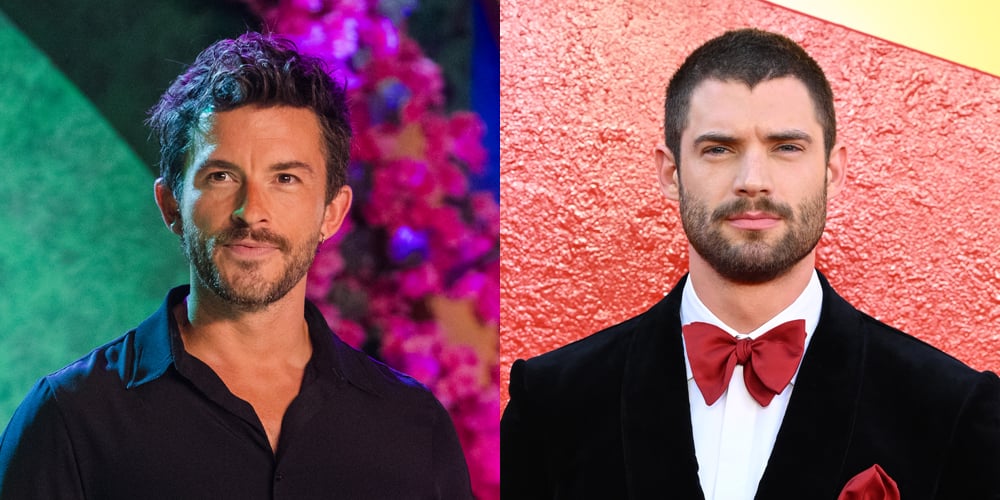

AGI tendrá que determinar qué personas son dignas de confianza y cuáles no.

getty

En la columna de hoy, examino una revelación algo sorprendente: no sólo los humanos tienen que determinar si están dispuestos a confiar en la IA, sino que, de manera similar, la IA debe determinar si deben confiar en los humanos. Sí, la situación está al revés en ese sentido. Esto será especialmente importante una vez que avancemos en la IA para lograr la Inteligencia General Artificial (AGI). En ese momento, se espera que casi todo el planeta utilice AGI a diario. AGI tendrá que decidir computacionalmente cuáles de los 8 mil millones de personas que habitan la Tierra son dignas de confianza y cuáles no.

Hablemos de ello.

Este análisis de un gran avance en inteligencia artificial es parte de mi columna actual de Forbes que cubre lo último en IA, incluida la identificación y explicación de las diversas complejidades de la IA impactante (ver enlace aquí).

Rumbo a AGI y ASI

En primer lugar, se necesitan algunos fundamentos para preparar el terreno para esta densa discusión.

Se están realizando muchas investigaciones para seguir avanzando en la IA. El objetivo general es alcanzar la inteligencia artificial general (AGI) o incluso la posibilidad ampliada de lograr la superinteligencia artificial (ASI).

AGI es una IA que se considera a la par de la inteligencia humana y aparentemente puede igualar nuestra inteligencia. ASI es una IA que ha superado el intelecto humano y sería superior en muchos, si no en todos, los aspectos posibles. La idea es que ASI podría dar vueltas alrededor de los humanos, burlándonos en todo momento. Para obtener más detalles sobre la naturaleza de la IA convencional frente a AGI y ASI, consulte mi análisis en el enlace aquí.

Aún no hemos alcanzado el AGI.

De hecho, no se sabe si alcanzaremos el AGI o si este será alcanzable dentro de décadas o tal vez siglos. Los logros de AGI que circulan por ahí son tremendamente variados y no están fundamentados por ninguna evidencia creíble o lógica firme. ASI es aún más atípico cuando se trata de nuestra situación actual con la IA convencional.

AGI debería creerle a todos los humanos

Abordemos la cuestión de AGI y cómo debería optar por confiar en los humanos.

Algunos creen que dado que los humanos crearon AGI, deberíamos esperar que AGI confíe en todos los humanos. El punto es que AGI necesita darse cuenta de que los humanos están en la cima del orden. Cualquier ser humano le dice al AGI que haga, por Dios, el AGI debe ejecutar sumariamente la orden o instrucción dada.

Punto, fin de la historia.

Bueno, ese no es el final de la historia.

Estoy seguro de que puedes adivinar por qué esta noción no es la mejor manera de abordar este espinoso enigma. Imaginemos que un villano accede al AGI y le dice que cree una nueva arma biológica. Bajo la regla de que la AGI debe confiar en todos los humanos, la AGI fácilmente sigue adelante y crea un arma biológica terriblemente poderosa. El malo agradece a AGI por su útil ayuda. Lo siguiente que sabes es que el villano desata el arma biológica y daña gravemente a la humanidad.

No es bueno.

El espectro de la confianza

No hay duda de que una apariencia general de confianza en todos los hombres es imprudente. El ejemplo del villano no sólo muestra el defecto de tal precepto, sino que también podemos considerar otro ángulo que fortalece aún más las dudas sobre tan idiota regla.

Dice así:

- ¿La gente confía en todas las demás personas?

En absoluto.

Al darnos cuenta de que la AGI debe estar a la par del intelecto humano, no debemos esperar que la AGI se aparte de la predilección humana por desconfiar de todos los humanos. De una manera quizás similar a cómo los humanos aprenden a confiar o desconfiar de sus semejantes, debemos darles a los AGI algunos medios para hacer lo mismo.

AGI tendrá que evaluar en qué personas confiar y en cuáles no.

Como aclaración, el acto de confiar en alguien no es necesariamente una dicotomía intermitente. Puedes tener una gran confianza en un querido amigo, pero al mismo tiempo tener una sensación de desconfianza hacia el mismo amigo en otros aspectos. Si tu amigo te dice que deberías invertir en una determinada acción, tal vez confíes en él y lo hagas. Por otro lado, si tu amigo te dice que puedes saltar por un acantilado y estar bien, probablemente ajustarás tu sentido de confianza y no llevarás a cabo una propuesta tan arriesgada.

Piense en ello como un espectro de confianza. Confías en algunas personas para determinadas tareas o consejos, mientras que con otras personas tienes una mayor sensación de desconfianza que de confianza en los mismos asuntos. Su sentido de confianza y desconfianza también cambia con el tiempo. Un buen amigo podría de repente ser deshonesto contigo. Como tal, ajuste rápidamente el nivel de confianza asociado con ese amigo.

La gente decide quién es digno de confianza en AGI

Quizás la gente debería decidir quién se considera digno de confianza.

Un enfoque comúnmente sugerido es obligar a AGI a obtener la aprobación previa de los humanos para confiar en otros humanos. Por lo tanto, no permitimos que AGI decida computacionalmente si confiar en los humanos. Depende completamente de lo que diferentes personas le hayan dicho a AGI sobre cómo mostrar confianza a otros pares.

Por ejemplo, supongamos que se elige un comité especial de personas para que sea el rey de confianza. Le dicen a la AGI en quién confiar y cuánto. Todos los días, este comité revisa minuciosamente a quienes utilizan AGI y brinda orientación sobre su confiabilidad. Esta no es una tarea única. El comité debe revisar y reajustar periódicamente las ponderaciones de confianza asociadas con los usuarios de AGI.

Intentar gestionar logísticamente un enfoque de este tipo es engorroso, poco práctico y puede generar sesgos hacia quienes reciben alta o baja confianza de AGI. La logística por sí sola es insoportable. La revisión rutinaria de la confiabilidad de probablemente 8 mil millones de usuarios de AGI es desalentadora e imposible por parte de un comité de este tipo.

Una variación es que permitimos que todas las personas califiquen a todas las demás. Algo así como una reseña de Yelp realizada mediante colaboración colectiva. Nuevamente, esto no es práctico y tiene muchas otras desventajas.

AGI necesitará generar confianza

Considerándolo todo, parece bastante claro que la única forma sensata es que AGI emita juicios confiables sobre los humanos. De alguna manera computacional, AGI necesitará determinar en quién confiar y cuánto, incluido realizar ajustes en tiempo real a esos valores de confianza.

Esto pone los pelos de punta a muchos especialistas en ética de la IA. Existe un gran peligro de que AGI opte por emitir estos juicios de confianza de manera injusta. Para ver mi amplia cobertura de estos dilemas éticos de la IA no resueltos, consulte el enlace aquí.

Un estudio de investigación reciente intentó identificar cómo la IA contemporánea evalúa la confianza del usuario. Si bien la IA actual no es AGI, podemos aprender mucho sobre cómo avanzar hacia AGI si comprendemos los entresijos de la IA en la era actual. El estudio se titula “Una mirada más cercana a cómo los grandes patrones lingüísticos ‘confían’ en las personas: patrones y sesgos” por Valeria Lermana y Yaniv Dovera. arXiv22 de abril de 2025 y destacó estos puntos importantes (extractos):

- “Aunque una considerable literatura estudia cómo los humanos confían en los agentes de IA, se comprende mucho menos cómo los agentes basados en LLM desarrollan una confianza efectiva en los humanos”.

- “En 43.200 experimentos simulados, para cinco modelos de lenguaje populares, en cinco escenarios diferentes, encontramos que el desarrollo de la confianza en LLM muestra una similitud general con el desarrollo de la confianza humana”.

- “Nos basamos en teorías psicológicas para comprender los mecanismos de cómo se puede descomponer y predecir esta confianza implícita de los agentes basados en LLM en humanos y, en consecuencia, cómo se puede afectar teóricamente”.

- “Encontramos que en la mayoría de los casos, pero no en todos, la confianza en LLM está fuertemente predicha por la credibilidad y, en algunos casos, también está sesgada por la edad, la religión y el género, particularmente en escenarios financieros”.

- “Aunque existen varias definiciones y operacionalizaciones de la confianza, una importante cantidad de literatura define la confianza como compuesta de tres dimensiones clave: capacidad (competencia), benevolencia e integridad”.

AGI se trata de hacer que las personas

Una lección de ese estudio es que quizás el camino a seguir sea considerar modelar el AGI para determinar la confianza de una manera similar a como lo hacen los humanos. En otras palabras, en lugar de reinventar la rueda y tratar de encontrar nuevos medios de confiabilidad, hagamos que AGI respete los medios humanos.

Como se mencionó, la confianza puede basarse en una variedad de dimensiones. Cada una de estas dimensiones se puede cuantificar. AGI podría apoyarse en estas dimensiones e intentar calificar a cada usuario en consecuencia. Este sería un elemento en funcionamiento continuo que AGI siempre mantendría en funcionamiento.

Incluso este enfoque humanoide plantea desafíos.

Por ejemplo, un nuevo usuario inicia sesión en AGI por primera vez. AGI no sabe nada sobre el usuario. ¿Cómo se puede medir adecuadamente cualquiera de estas dimensiones cuando falta información disponible sobre la persona? Esto sería cierto en el caso de un humano que juzga a otro humano basándose en su confiabilidad, es decir, que cuando conoces a alguien por primera vez, generalmente tienes poca idea de en qué debería ser digno de confianza.

Otra posible complicación es que alguien se quede atrapado en una rutina de confianza. Quizás el AGI evalúe a la persona y le dé una puntuación de confianza bastante baja. En este punto, la persona está en el sótano y puede que tenga pocas esperanzas de salir. El AGI podría aumentar gradualmente el valor de confianza para esa persona, mientras que se la trata principalmente con desconfianza.

Zapato en el otro pie

A algunos les sorprende un poco que tengamos que preocuparnos de cómo AGI decidirá confiar en los humanos. Casi todo el enfoque en el tema general de la IA y la confianza tiene que ver con que las personas se sientan reconfortadas sobre cómo confiar en la IA. Existe una base de investigación considerable sobre este tema que aún está en evolución; consulte mi revisión en profundidad en el enlace aquí.

En el caso de AGI, decidir si debemos confiar en AGI es ciertamente una consideración importante. Si vamos a confiar en AGI para que nos ayude en nuestro trabajo y juego, eso es mucha confianza para una máquina. Ya sabemos que la IA actual puede encontrar confabulaciones de IA que están inventadas y no basadas en hechos reales, comúnmente conocidas como alucinaciones de IA; consulte mi cobertura en el enlace aquí.

Digamos que AGI hace lo mismo. Probablemente tendremos 8 mil millones de personas usando AGI, y un porcentaje de las veces el AGI dará respuestas extrañas. Es posible que las personas asuman fundamentalmente que el AGI es confiable y acepten las recomendaciones potencialmente extrañas emitidas por el AGI. Esto podría incluir señales dañinas que inducen a error a las personas a hacer cosas peligrosas.

Parece que debemos preocuparnos por la dualidad de la confianza, que consiste en que los humanos confíen en el AGI, junto con cómo el AGI concebirá la confiabilidad de los humanos. Es una ecuación bastante compleja. Deberíamos arreglar las cosas antes de llegar al AGI o quedar atrapados en una maraña de confianza y desconfianza complicadas.

En palabras de Charles H. Green: “Se necesitan dos para hacer el tango de la confianza: el que toma riesgos (el que confía) y el que confía (el que confía); cada uno debe desempeñar su papel”. Esto se aplica plenamente a la vía de confianza de doble sentido entre la humanidad y AGI.