O hardware acelerado por IA está a tornar-se cada vez mais caro, à medida que os chips da próxima geração exigem elevados orçamentos de energia e grandes investimentos em infra-estruturas. Para muitas startups e empresas menores, o custo e a complexidade da implantação de IA em escala criam barreiras muito antes do início do desenvolvimento de software.

Novos players de silício como a FuriosaAI estão tentando repensar essa equação, concentrando-se em eficiência, desempenho e abordagens alternativas para o mercado dominado por GPU.

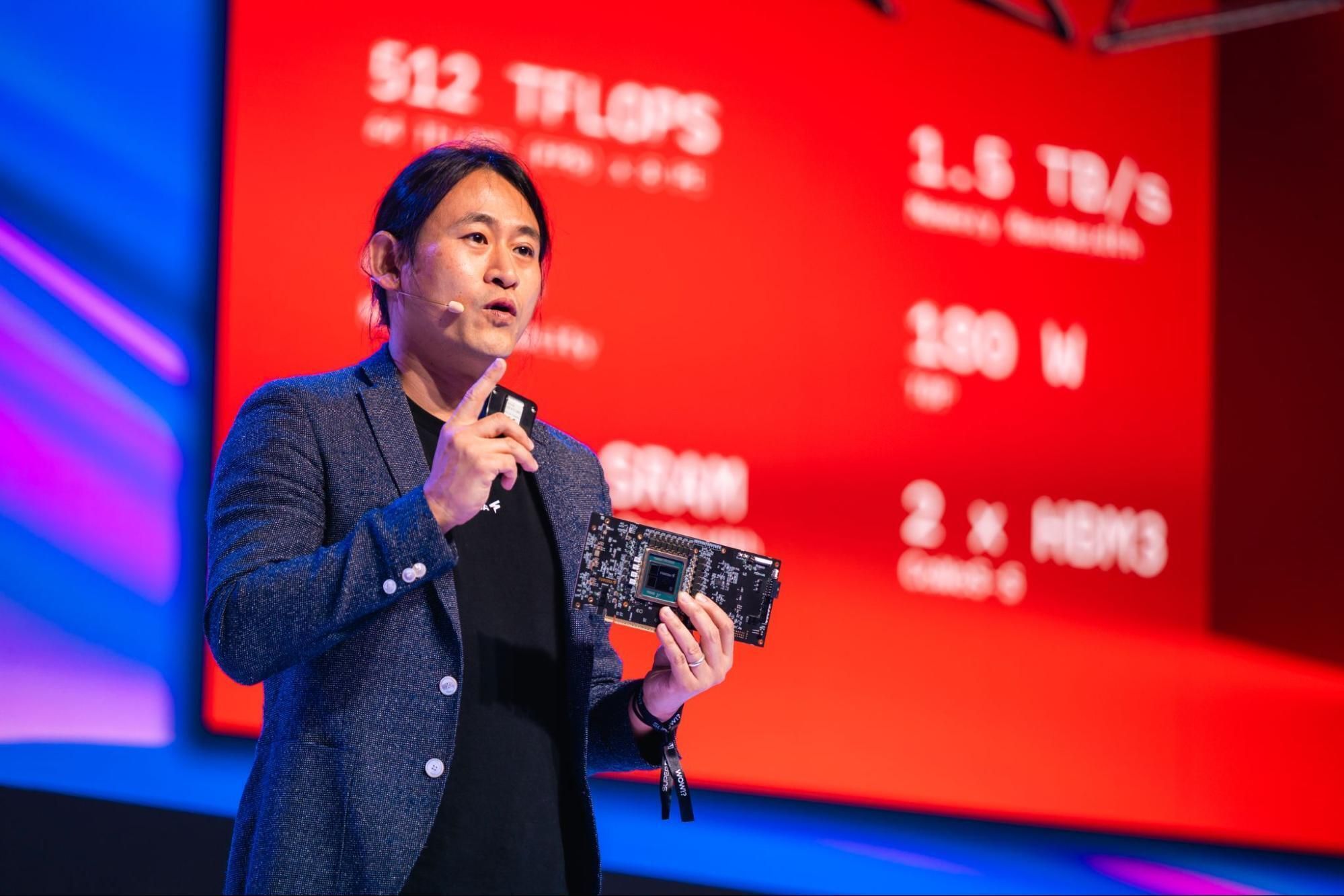

Fundada na Coreia do Sul, a FuriosaAI desenvolve chips de inferência de IA projetados para oferecer alto desempenho e, ao mesmo tempo, reduzir o consumo de energia e a sobrecarga do data center. Seu processador mais recente, RNGD, é construído em torno da arquitetura Tensor Contraction Processor da empresa e tem como objetivo executar modelos de IA exigentes sem depender de estruturas de GPU tradicionais.

- Historicamente, o Japão e a Europa produziram grandes empresas (ST Electronics, NEC, etc.). Por que existem tão poucos players de silício de IA fora da China e dos EUA?

Primeiro, eu questionaria sua premissa, pelo menos um pouco: poucas startups de hardware chegaram a algum lugar contra o domínio da IA da Nvidia. Mesmo uma década e meia depois da AlexNet, ainda estamos nos primórdios desta indústria. E alguns hardwares inovadores de IA, como Hailo e Axelera, tiveram origem fora dos EUA ou da China.

Mas a lista é curta por razões estruturais.

Ao contrário da mineração de criptografia, onde os algoritmos são fixos e os ASICs simples funcionam perfeitamente, a IA está avançando e evoluindo rapidamente.

Construir um chip para um alvo móvel requer experiência em hardware e compilador que tende a se concentrar em locais com forte herança de semicondutores. Existem também poucas partes do mundo que mantêm relacionamentos profundos com fabricantes e parceiros na fabricação de chips.

Portanto, estar na Coreia do Sul foi uma vantagem competitiva para a Furiosa.

Tivemos acesso a talentos de programas de engenharia de classe mundial em universidades coreanas e gigantes da tecnologia coreanas. Também conseguimos desenvolver parcerias com empresas líderes na Coreia (SK Hynix fornecerá HBM3 para nosso chip de inferência de segunda geração, RNGD) e em outros lugares da Ásia (como nosso parceiro de fundição em Taiwan, TSMC).

Também nos forçou a nos distanciarmos de forma muito disciplinada do Vale do Silício. A Furiosa foi lançada com US$ 1 milhão em financiamento inicial e passou vários anos refinando nossas ideias antes de enviá-las para o silício.

Estávamos totalmente comprometidos com a abordagem de contração por tração e fomos capazes de ignorar a sabedoria convencional do vale e o hype.

Mas o hardware deve competir num mercado global; não podemos ser um fornecedor regional. Agora que enviamos RNGD em grande volume, estamos trabalhando com clientes empresariais em todo o mundo.

- O hardware é apenas parte da equação e a Nvidia levou anos para desenvolver seu software luban (CUDA). O que Furiosa está fazendo para competir com seu formidável rival?

Tentar replicar a enorme biblioteca CUDA da Nvidia é um extremo estratégico.

Seguimos um caminho mais ousado ao projetar conjuntamente nosso hardware e software a partir de princípios básicos especificamente para IA, para que não precisássemos reinventar o CUDA.

Nossos chips usam a arquitetura Tensor Contraction Processor (TCP) proprietária da Furiosa, que executa matemática multidimensional de aprendizado profundo nativamente, em vez de ser forçado a estruturas legadas usadas por GPUs.

Isso permite que nosso compilador otimize modelos sem a necessidade de milhares de núcleos ajustados manualmente.

O RNGD, agora em produção em massa, demonstra as vantagens da nossa abordagem. Ele fornece inferência de alto desempenho para os modelos mais exigentes do mundo, consumindo apenas 180 watts (em comparação com os 600 ou mais watts exigidos pelas GPUs).

Parceiros globais como a LG AI Research verificaram esta eficiência inovadora na produção.

Também resolvemos o gargalo do CUDA ao construir nossa pilha de software para integração perfeita com ferramentas padrão como PyTorch e vLLM, para que os desenvolvedores possam acessar esse desempenho sem alterar seu fluxo de trabalho.

- Lentamente, os maiores hiperscaladores estão construindo suas próprias soluções de chips de IA (Google, Microsoft, Amazon) para reduzir a dependência de terceiros. Onde Furiosa (e outros) se encaixa nesse quadro?

O paradigma atual da GPU está criando desafios energéticos e gargalos de infraestrutura para toda a indústria, incluindo hiperscaladores. Prevemos um futuro definido pela computação heterogênea, onde diferentes arquiteturas trabalhem lado a lado para atender de forma mais eficiente às diferentes necessidades (por exemplo, treinamento versus inferência).

À medida que priorizamos o TCO, a eficiência energética e a flexibilidade, a nossa tecnologia desempenhará um papel central na resolução deste problema para todos.

Neste momento, estamos focando em quatro setores específicos que sentem mais força e infra-dores de cabeça:

● As nações e as indústrias regulamentadas devem trabalhar com dados sensíveis localmente e não numa nuvem pública. A RNGD permite-lhes implementar inferência de alto desempenho em estruturas de energia existentes, garantindo a soberania dos dados sem a necessidade de novos projetos massivos de infraestrutura.

● Para clientes empresariais, o TCO e a flexibilidade são fundamentais. O RNGD cabe em racks refrigerados a ar padrão de 15 kW e evita as dispendiosas alterações de refrigeração líquida exigidas pelas GPUs legadas, tornando-o a maneira mais rápida e econômica de escalar.

● As nuvens regionais e especializadas precisam competir com as 3 Grandes nas margens. A alta densidade computacional do RNGD permite que os CSPs maximizem a receita por rack, mantendo o OpEx baixo.

● Outros setores, como a televisão, trabalham com ambientes de data center com restrição de energia na extremidade da rede. A eficiência energética da RNGD também responde às suas necessidades.

Nosso chip de próxima geração, atualmente em desenvolvimento, terá como alvo hiperscaladores diretamente próximos a esses setores-chave.

- Como você vê a evolução do futuro do data center (você está visitando um data center em 2036, o que você vê lá dentro)?

Em 10 anos, “data center” significará muitas coisas diferentes, assim como “computador” significará tudo, desde seu smartwatch até seu servidor de alto desempenho.

Alguns data centers terão o tipo de configuração futurística que você está imaginando: enormes e (provavelmente) movidos a fusão ou orbitando a Terra. Mas outros serão pequenos e hipereficientes.

Por exemplo, o hospital local terá um data center local de IA para executar assistentes inteligentes para médicos e enfermeiros, mantendo a latência baixa e os dados locais e seguros.

As empresas de telecomunicações terão muitos data centers de IA de “borda” de alto desempenho, otimizados para latência ultrabaixa.

Uma coisa que tenho certeza é que os data centers de IA de 2036 não estarão cheios de GPUs. Será silício específico para IA para diversas necessidades.

Isto se deve em parte à ineficiência energética das GPUs. Mas, basicamente, há um amplo consenso de que a arquitetura da GPU não é ideal para IA.

Os fabricantes de GPU têm trabalhado para preencher essa lacuna com inovações como a adição de núcleos tensores aos seus chips, mas eventualmente os benefícios de mudar de GPUs para arquiteturas AI-first serão grandes demais para serem ignorados.

- Sem dar muitos detalhes ao seu roteiro, o silício Furiosa seguirá o caminho tradicional dos produtos de IA?

Nossa visão com nossos produtos agora e no futuro é fornecer o que os clientes corporativos mais precisam: inferência de data center de alto desempenho que seja eficiente em termos energéticos, econômico e fácil de implantar sem aumentar a infraestrutura.

Isso significa priorizar medidas de tokens por watt e tokens por rack para maior densidade computacional.

Também aproveitaremos agressivamente os novos avanços da indústria, como nós menores e novas tecnologias de memória.

Nosso chip de primeira geração usava um nó de 14 nanômetros. Nosso chip RNGD usa HBM3 e um nó de 5 nanômetros e continuaremos. Mas é a nossa inovação arquitetônica que nos permite alcançar melhor desempenho e mais eficiência energética do que GPUs construídas no mesmo nó.

Outra coisa sobre nosso roteiro é que ele trata tanto de software quanto de hardware. A Furiosa tem mais engenheiros de software do que engenheiros de hardware porque precisamos continuar a oferecer suporte a novos modelos e ferramentas de implantação de forma rápida e eficiente.

Lançamos três atualizações importantes do SDK em 2025 e continuaremos nesse ritmo em 2026 e além.

- Furiosa é da Coreia do Sul. Como os gigantes Chaebol (Samsung, LG, Hyundai, SK Hynix) veem esta startup? Que parcerias existem hoje?

Trabalhamos com os principais líderes tecnológicos coreanos como parceiros e clientes: a Samsung Foundry fabricou nosso chip de primeira geração, a SK Hynix fornece memória HBM3 para RNGD e a LG é agora um principal cliente empresarial que expande nosso silício. São relacionamentos profundos criados ao longo de muitos anos.

Além dos conglomerados, estamos trabalhando com startups globalmente competitivas, como a AI Upstage, sediada na Coreia, beneficiando-se dos consumidores coreanos experientes em IA e de grandes bases industriais nos setores automotivo, de construção naval e outros.

A IA também é uma das principais prioridades políticas do governo coreano. O presidente coreano estabeleceu iniciativas ambiciosas para tornar a IA uma potência global, com chips de IA no centro.

Estamos muito entusiasmados com o impulso da Coreia na IA, que irá melhorar o novo ecossistema que estamos construindo para levar a indústria além das GPUs.

Siga o TechRadar no Google Notícias e adicione-nos como sua fonte padrão para receber notícias, opiniões e opiniões de nossos especialistas em feeds. Certifique-se de clicar no botão Continuar!

E é claro que você também pode Siga o TechRadar no TikTok para receber novidades, análises, unboxings em formato de vídeo e receber atualizações constantes nossas WhatsApp também